NVIDIA GeForce GTX TITAN - за 1000 долларов. Новый удар по позициям AMD в верхнем ценовом диапазоне

Современный рынок графических решений на протяжении длительного времени не может предложить пользователям чего-либо кардинально нового, что достаточно печально. Но еще в момент анонса видеокарт серии NVIDIA GeForce GTX 680 было ясно, что данный продукт не последний в семействе, так как он был основан на ядре GK104. Так как видеокарта NVIDIA GeForce GTX 680 увидела свет на целый квартал позже, чем топовый продукты AMD Radeon HD 7970 - производитель просто решил не демонстрировать свой козырь на базе ядра GK110, ведь продукт на базе чипа GK104 вполне опережал продукт конкурента как по производительности, так и по энергопотреблению.

Расклад сил поменялся во втором полугодии 2012 года, когда AMD достаточно агрессивно вначале произвела более детальную настройку своих драйверов для видеокарт, а затем анонсировала видеокарты AMD Radeon HD 7970 Ghz Edition, которые переняли технологию автоматического разгона, которая уже имелась у видеокарт NVIDIA - GPU Boost. Тем самым, самой производительной одночиповой видеокартой вновь оказалась видеокарта от AMD - Radeon HD 7970 Ghz Edition. Видимо, данное положение дел не устраивает NVIDIA и она решила нанести достаточно сокрушительный удар не только по сегменту самых производительных одночиповых видеокарт, но и противопоставить новый продукт NVIDIA GeForce GTX TITAN таким двухчиповым решениям, как NVIDIA GeForce GTX 690 и AMD Radeon HD 7990, которые имеют аналогичную стоимость, но являются двухчиповыми решениями, тем самым работают по принципу связки NVIDIA SLI или AMD CrossFireX.

Казалось бы, зачем компании NVIDIA противопоставлять конкурента своему же продукту - NVIDIA GeForce GTX 690? Ответ ясен только тем пользователям, которые на практике использовали технологии NVIDIA SLI и AMD CrossFireX. Проблема обоих данных технологий заключается в том, что они эффективны только в том случае, если запускаемое приложение их поддерживает, а само приложение поддерживает драйвер видеокарт. В противном случае пользователь довольствуется низким приростом производительности от второй видеокарты или вовсе отсутствием какого-либо прироста. Все это достаточно печально, но факт. Да и технологии NVIDIA SLI и AMD CrossFireX не во всех приложениях еще избавились от такого паразитического эффекта, как "фризы". Фризы - это мелкие подергивания изображения, которые заметны исключительно пользователю и не фиксируются никаким программами. Фризы возникают из-за малейшей разницы в уровне производительности двух графических ядер и достаточно трудно поддаются "лечению".

Новый продукт NVIDIA GeForce GTX TITAN основан на единственном крупном ядре GPU GK110. Результаты тестов показывают, что данная видеокарта является наиболее производительной среди всех существующих одночиповых видеокарт, но во многих играх уступает двухчиповым решениям NVIDIA GeForce GTX 690 и AMD Radeon HD 7990. При этом видеокарта NVIDIA GeForce GTX TITAN имеет сопоставимую с ними стоимость. Тем самым, пользователь приобретая NVIDIA GeForce GTX TITAN получает следующие преимущества перед покупкой NVIDIA GeForce GTX 690 и AMD Radeon HD 7990:

- меньший уровень энергопотребления,

- стабильную производительность, не зависящую от готовности драйверов, программ к работе с двухчиповыми видеокартами,

- отсутствие фризов,

- меньший уровень тепловыделения,

- меньший уровень шума от системы охлаждения,

- продукт на одном ядре, который будет лидером по уровню производительности еще долгое время.

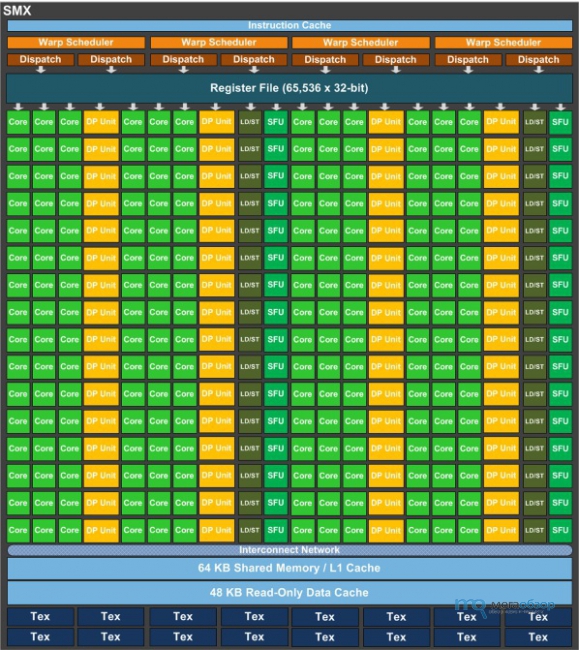

Видеокарта основана на ядре GK110, которое имеет 2688 ядер CUDA, 225 текстурных блока и 28 ROP модулей. К примеру, решение GeForce GTX 680 имеет всего 1536 CUDA ядер, что позволяет оценить превосходство новой видеокарты.

Видеокарта NVIDIA GeForce GTX TITAN имеет рабочую частоту 836 Мгц, которая благодаря технологии GPU Boost 2.0 повышает рабочую частоту до 876 Мгц.

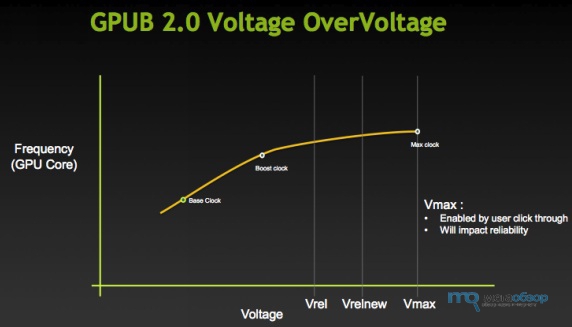

Обновленная технология GPU Boost 2.0 теперь при разгоне графического ядра учитывает не только потребляемую мощность видеокартой, но и ее рабочую температуру. Поэтому теперь пользователь может регулировать оба параметра и, самое главное, самостоятельно повышать рабочее напряжение на графическом ядре. При этом технология GPU Boost 2.0 самостоятельно управляет повышением рабочей частоты, с учетом установленных лимитов энергопотребления и рабочей температуры.

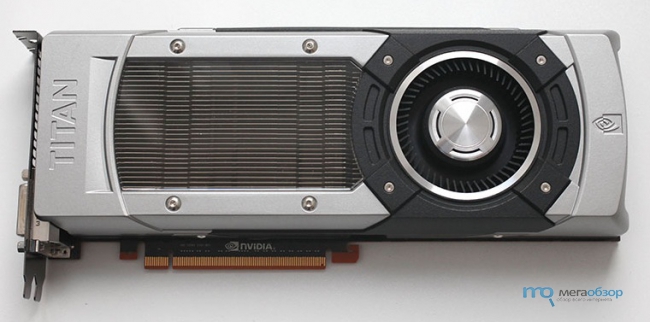

Внешне видеокарта ничем не отличается от других топовых продуктов NVIDIA. Плата двухслотная, достаточно длинная. Установлена система охлаждения на базе теплоиспарительной камеры и турбины охлаждения, выдувающей воздух за пределы системного блока.

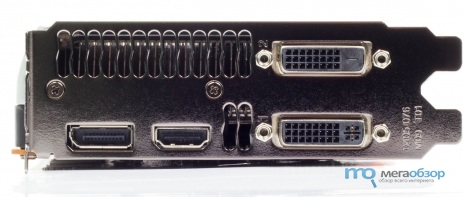

Видеокарта NVIDIA GeForce GTX TITAN имеет стандартный набор портов для вывода изображения - два DVI, HDMI, DisplayPort.

На боковой поверхности видеокарты расположены два коннектора SLI, для подключения мостиков и объединения вычислительной возможности нескольких видеокарт.

На боковой поверхности имеется два коннектора для подачи дополнительного питания на видеокарту - шестипиновый и восьмипиновый.

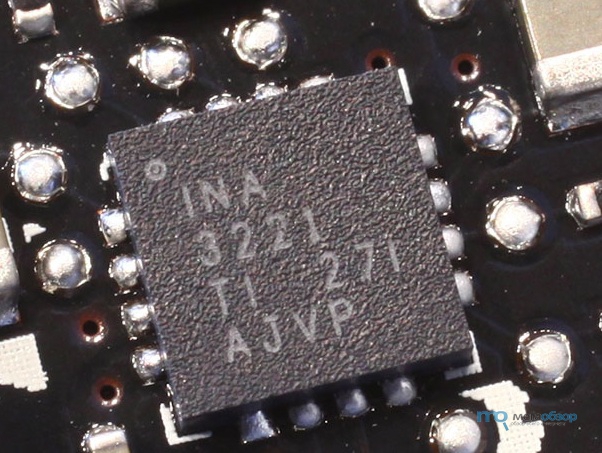

На видеокарте имеется схема INA 3221, которая отвечает за контроль за уровнем энергопотребления.

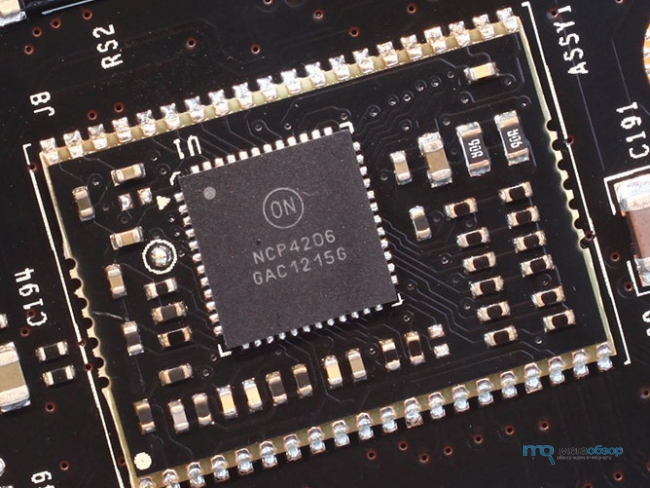

Схема питания видеокарты восьмифазная и организована по схеме 6+2. В качестве контроллера напряжения выступает чип OnSemi NCP4206.

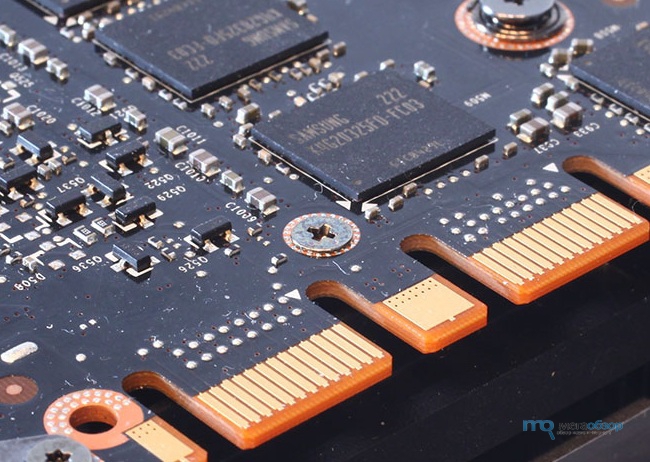

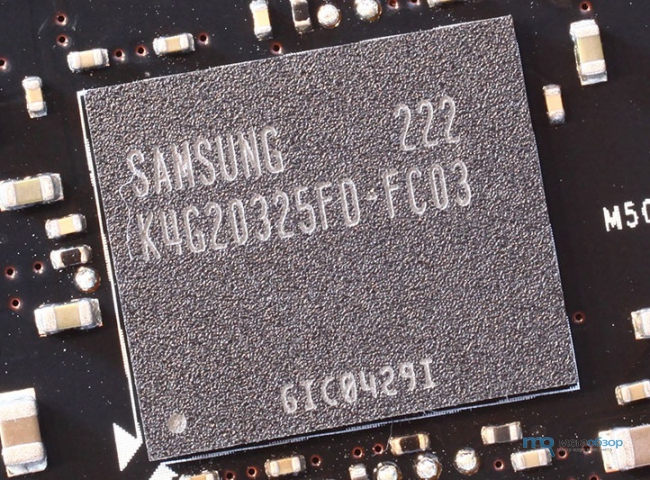

На видеокарте распаяны чипы видеопамяти Samsung K4G20325FD-FC03 типа GDDR5, с рабочей частотой 1500 Мгц.

Само ядро видеокарты GK110 значительно увеличилось в размерах и достигло 521 квадратных миллиметров. Для сравнения, ядро GK104 видеокарт GeForce GTX 680 имеет площадь всего 294 квадратных миллиметра. Именно данное обстоятельство говорит нам о том, что врятли мы когда-либо увидим видеокарту NVIDIA GeForce GTX TITAN со стоимостью в 500 долларов - это не возможно.

Спецификации видеокарты

1. Рабочая частота ядра: 840 МГц, турбо частота - 876 Мгц

2. Универсальных процессоров CUDA: 2688

3. Тип памяти: GDDR5

4. Объем памяти: 6 Гб

5. Рабочая частота видеопамяти: 1502 МГц

6. Шина 384 битная

7. Шина PCI Express 3.0

8. Рекомендованная стоимость: $1000 долларов для США

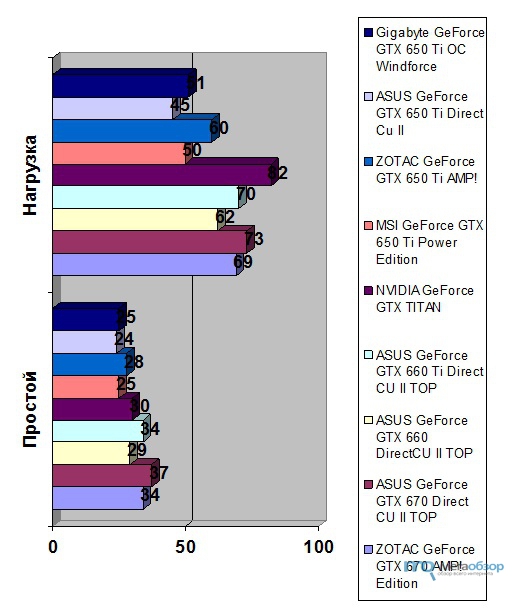

1. Температурный режим работы видеокарты

Видеокарта тестировалась при следующих условиях:

- в комнате 27 градусов,

- видеокарта установлена в закрытый корпус,

- в корпусе нет дополнительных вентиляторов охлаждения,

- нагрузка подается до полной стабилизации температур в течение 15 минут.

Результаты тестирования показывают, что система охлаждения видеокарты справляется со своими задачами. Новая система GPU Boost 2.0 даже при разгоне не позволит нарушить данный температурный режим работы продукта.

2. Разгон видеокарты

На сегодняшний день достоверно известно, что некоторые экземпляры NVIDIA GeForce GTX TITAN без проблем берут частоту в 1005 Мгц по ядру и 1755 Мгц по видеопамяти.

Заключение

Видеокарта NVIDIA GeForce GTX TITAN является новым достаточно интересным решением, которое является конкурентом именно двухчиповым видеокартам как NVIDIA, так и AMD. Естественно, новый продукт перетянет на себя многих потенциальных покупателей видеокарт AMD Radeon HD 7990 в связи с указанными во вводной части статьи преимуществами решения NVIDIA GeForce GTX TITAN.

Расклад сил поменялся во втором полугодии 2012 года, когда AMD достаточно агрессивно вначале произвела более детальную настройку своих драйверов для видеокарт, а затем анонсировала видеокарты AMD Radeon HD 7970 Ghz Edition, которые переняли технологию автоматического разгона, которая уже имелась у видеокарт NVIDIA - GPU Boost. Тем самым, самой производительной одночиповой видеокартой вновь оказалась видеокарта от AMD - Radeon HD 7970 Ghz Edition. Видимо, данное положение дел не устраивает NVIDIA и она решила нанести достаточно сокрушительный удар не только по сегменту самых производительных одночиповых видеокарт, но и противопоставить новый продукт NVIDIA GeForce GTX TITAN таким двухчиповым решениям, как NVIDIA GeForce GTX 690 и AMD Radeon HD 7990, которые имеют аналогичную стоимость, но являются двухчиповыми решениями, тем самым работают по принципу связки NVIDIA SLI или AMD CrossFireX.

Казалось бы, зачем компании NVIDIA противопоставлять конкурента своему же продукту - NVIDIA GeForce GTX 690? Ответ ясен только тем пользователям, которые на практике использовали технологии NVIDIA SLI и AMD CrossFireX. Проблема обоих данных технологий заключается в том, что они эффективны только в том случае, если запускаемое приложение их поддерживает, а само приложение поддерживает драйвер видеокарт. В противном случае пользователь довольствуется низким приростом производительности от второй видеокарты или вовсе отсутствием какого-либо прироста. Все это достаточно печально, но факт. Да и технологии NVIDIA SLI и AMD CrossFireX не во всех приложениях еще избавились от такого паразитического эффекта, как "фризы". Фризы - это мелкие подергивания изображения, которые заметны исключительно пользователю и не фиксируются никаким программами. Фризы возникают из-за малейшей разницы в уровне производительности двух графических ядер и достаточно трудно поддаются "лечению".

Новый продукт NVIDIA GeForce GTX TITAN основан на единственном крупном ядре GPU GK110. Результаты тестов показывают, что данная видеокарта является наиболее производительной среди всех существующих одночиповых видеокарт, но во многих играх уступает двухчиповым решениям NVIDIA GeForce GTX 690 и AMD Radeon HD 7990. При этом видеокарта NVIDIA GeForce GTX TITAN имеет сопоставимую с ними стоимость. Тем самым, пользователь приобретая NVIDIA GeForce GTX TITAN получает следующие преимущества перед покупкой NVIDIA GeForce GTX 690 и AMD Radeon HD 7990:

- меньший уровень энергопотребления,

- стабильную производительность, не зависящую от готовности драйверов, программ к работе с двухчиповыми видеокартами,

- отсутствие фризов,

- меньший уровень тепловыделения,

- меньший уровень шума от системы охлаждения,

- продукт на одном ядре, который будет лидером по уровню производительности еще долгое время.

Видеокарта основана на ядре GK110, которое имеет 2688 ядер CUDA, 225 текстурных блока и 28 ROP модулей. К примеру, решение GeForce GTX 680 имеет всего 1536 CUDA ядер, что позволяет оценить превосходство новой видеокарты.

Видеокарта NVIDIA GeForce GTX TITAN имеет рабочую частоту 836 Мгц, которая благодаря технологии GPU Boost 2.0 повышает рабочую частоту до 876 Мгц.

Обновленная технология GPU Boost 2.0 теперь при разгоне графического ядра учитывает не только потребляемую мощность видеокартой, но и ее рабочую температуру. Поэтому теперь пользователь может регулировать оба параметра и, самое главное, самостоятельно повышать рабочее напряжение на графическом ядре. При этом технология GPU Boost 2.0 самостоятельно управляет повышением рабочей частоты, с учетом установленных лимитов энергопотребления и рабочей температуры.

Внешне видеокарта ничем не отличается от других топовых продуктов NVIDIA. Плата двухслотная, достаточно длинная. Установлена система охлаждения на базе теплоиспарительной камеры и турбины охлаждения, выдувающей воздух за пределы системного блока.

Видеокарта NVIDIA GeForce GTX TITAN имеет стандартный набор портов для вывода изображения - два DVI, HDMI, DisplayPort.

На боковой поверхности видеокарты расположены два коннектора SLI, для подключения мостиков и объединения вычислительной возможности нескольких видеокарт.

На боковой поверхности имеется два коннектора для подачи дополнительного питания на видеокарту - шестипиновый и восьмипиновый.

На видеокарте имеется схема INA 3221, которая отвечает за контроль за уровнем энергопотребления.

Схема питания видеокарты восьмифазная и организована по схеме 6+2. В качестве контроллера напряжения выступает чип OnSemi NCP4206.

На видеокарте распаяны чипы видеопамяти Samsung K4G20325FD-FC03 типа GDDR5, с рабочей частотой 1500 Мгц.

Само ядро видеокарты GK110 значительно увеличилось в размерах и достигло 521 квадратных миллиметров. Для сравнения, ядро GK104 видеокарт GeForce GTX 680 имеет площадь всего 294 квадратных миллиметра. Именно данное обстоятельство говорит нам о том, что врятли мы когда-либо увидим видеокарту NVIDIA GeForce GTX TITAN со стоимостью в 500 долларов - это не возможно.

Спецификации видеокарты

1. Рабочая частота ядра: 840 МГц, турбо частота - 876 Мгц

2. Универсальных процессоров CUDA: 2688

3. Тип памяти: GDDR5

4. Объем памяти: 6 Гб

5. Рабочая частота видеопамяти: 1502 МГц

6. Шина 384 битная

7. Шина PCI Express 3.0

8. Рекомендованная стоимость: $1000 долларов для США

1. Температурный режим работы видеокарты

Видеокарта тестировалась при следующих условиях:

- в комнате 27 градусов,

- видеокарта установлена в закрытый корпус,

- в корпусе нет дополнительных вентиляторов охлаждения,

- нагрузка подается до полной стабилизации температур в течение 15 минут.

Результаты тестирования показывают, что система охлаждения видеокарты справляется со своими задачами. Новая система GPU Boost 2.0 даже при разгоне не позволит нарушить данный температурный режим работы продукта.

2. Разгон видеокарты

На сегодняшний день достоверно известно, что некоторые экземпляры NVIDIA GeForce GTX TITAN без проблем берут частоту в 1005 Мгц по ядру и 1755 Мгц по видеопамяти.

Заключение

Видеокарта NVIDIA GeForce GTX TITAN является новым достаточно интересным решением, которое является конкурентом именно двухчиповым видеокартам как NVIDIA, так и AMD. Естественно, новый продукт перетянет на себя многих потенциальных покупателей видеокарт AMD Radeon HD 7990 в связи с указанными во вводной части статьи преимуществами решения NVIDIA GeForce GTX TITAN.

NVIDIA сокращает производство видеокарт…

Проблемы на рынке затрагивают уже не отдельные модели видеокарт, а, похоже, всю линейку RTX 50 в целом, п…

Проблемы на рынке затрагивают уже не отдельные модели видеокарт, а, похоже, всю линейку RTX 50 в целом, п…

AMD не планирует повышать цены на видеокарты…

Рост цен на видеокарты уже практически неизбежен и продолжает ускоряться из-за серьёзного дефицита DRAM, …

Рост цен на видеокарты уже практически неизбежен и продолжает ускоряться из-за серьёзного дефицита DRAM, …

ASUS представила видеокарту Dual RTX 5070 Evo…

В конце 2025 года компания ASUS представила видеокарты NVIDIA GeForce RTX 5060 и NVIDIA GeForce RTX 5060 …

В конце 2025 года компания ASUS представила видеокарты NVIDIA GeForce RTX 5060 и NVIDIA GeForce RTX 5060 …

В сеть выложили BIOS для разгона RTX 5090…

Если вам казалось, что 600 Вт для видеокарты слишком уж скромно, появился шанс попробовать чудовищный кас…

Если вам казалось, что 600 Вт для видеокарты слишком уж скромно, появился шанс попробовать чудовищный кас…

ASUS всё же не снимает с производства RTX 5070 Ti…

Рынок видеокарт снова начинает превращаться в хаос. Ранее на этой неделе ASUS сообщила Hardware Unboxed, …

Рынок видеокарт снова начинает превращаться в хаос. Ранее на этой неделе ASUS сообщила Hardware Unboxed, …

AMD Radeon RX 9070 впервые появилась в статистике Steam…

Видеокарты AMD Radeon RX 9070 впервые появились в статистике Steam Hardware Survey, однако они пока замет…

Видеокарты AMD Radeon RX 9070 впервые появились в статистике Steam Hardware Survey, однако они пока замет…

Видеокарта Intel Arc B370 засветилась в бенчмарке…

Интегрированная графика Intel Arc B370 прошла тестирование в FurMark и продемонстрировала заметный прирос…

Интегрированная графика Intel Arc B370 прошла тестирование в FurMark и продемонстрировала заметный прирос…

NVIDIA внедрила ИИ в разработку видеокарт…

Компания, которая фактически запустила всю волну развития ИИ-инфраструктуры и искусственного интеллекта, …

Компания, которая фактически запустила всю волну развития ИИ-инфраструктуры и искусственного интеллекта, …